本学习报告基于《》,该文献发表在人工智能顶级会议ijcai2022上,由深圳大学计算机视觉所以及剑桥大学情感智能与机器人实验室合作完成。该工作提出了一种新的图神经网络gnn模型——基于多维边缘特征的图网络。该图网络被应用于情感计算领域中的经典任务——人脸运动单元识别中,能够对人脸部肌肉的运动准确建模,表达运动单元之间复杂的类别、共生互斥以及空间位置等关系。

1.背景

面部动作编码系统(facial action coding system,friesenand ekman,1978)通过一组称为动作单元(action units,aus)的面部肌肉运动来表示人脸。与基于情绪的分类人脸表情模型相比,aus对人类面部表情的描述更加全面和客观。人脸au识别是一个多标签分类问题,因为多个au可以同时被激活。虽然之前的研究发现aus激活之间的潜在关系对它们的识别至关重要,但如何正确地对这种关系进行建模仍然是该领域的一个开放研究问题。

2.gnn

2.1基于多维边缘特征表示节点关系

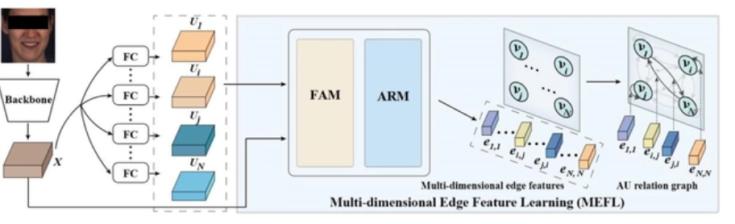

本文提出一种新的au关系建模方法来解决上述问题,可以轻松地与各种深度学习骨架结合。它将由backbone生成的完整人脸表示作为输入,输出一个aus关系图,该图显式描述了每对aus之间的关系。

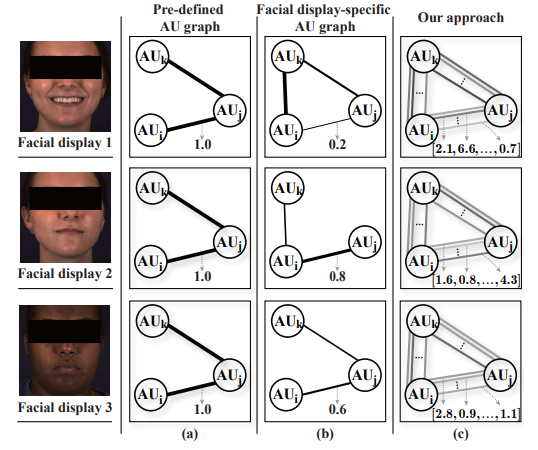

在深度学习中,神经网络经常被采用对单一图像提取抽象的表示特征。这种特征通常是多维度的,表示性强的,甚至能被用于图像的复原。作者想到既然复杂图像信息被编码到这些多维特征中,那图像元素之间的复杂关系也应同样能被多维特征表示。基于此,作者首先在图像分类领域中构建出基于多维边缘特征来表示节点关系的图神经网络。多种表示节点关系的方式比较如图1所示。

图1.节点关系表示方法的比较

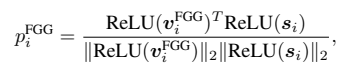

2.2节点特征学习

如图2所示,anfl模块由两个模块组成:au特定的特征生成器(afg)和面部图形生成器(fgg)。afg为每个au单独生成一个表示,在此基础上,fgg自动为每个面部显示设计一个最佳图,旨在准确识别所有目标au。为了实现这一点,fgg将强制afg将au之间特定于任务的关联编码为特定于au的表示。afg由n个au特定的特征提取器组成,每个提取器包含一个全连接层(fc)和一个全局平均池化层(gap)。它以全面表示![]() 为输入,可由任何标准机器学习主干生成。第i个au特定特征提取器的fc层首先将x投影到au特定特征映射

为输入,可由任何标准机器学习主干生成。第i个au特定特征提取器的fc层首先将x投影到au特定特征映射![]() ,然后将其馈送到gap层,得到包含c值的向量作为第i个au的表示

,然后将其馈送到gap层,得到包含c值的向量作为第i个au的表示![]() 。因此,可以分别从全面表示x中学习n个au表示。作者的假设是,对于每个面部显示,au之间的关系线索都是唯一的。因此,直接利用训练集中定义的关系线索(例如,共现模式)可能无法在推理阶段很好地泛化。因此,作者建议将每个面部显示中的au关系表示为一个唯一的图,该图考虑了目标面部显示对au关系的影响。对于人脸图像,fgg块将n个目标aus的特征向量

。因此,可以分别从全面表示x中学习n个au表示。作者的假设是,对于每个面部显示,au之间的关系线索都是唯一的。因此,直接利用训练集中定义的关系线索(例如,共现模式)可能无法在推理阶段很好地泛化。因此,作者建议将每个面部显示中的au关系表示为一个唯一的图,该图考虑了目标面部显示对au关系的影响。对于人脸图像,fgg块将n个目标aus的特征向量![]() 作为n个节点特征,通过特征的相似度(

作为n个节点特征,通过特征的相似度(![]() =

=![]() )定义一对节点

)定义一对节点![]() 和

和![]() 之间的连通性(边缘存在性)。具体来说,作者选择每个节点的k个最近的邻居作为它的邻居,因此图的拓扑是由学习到的节点特征定义的。然后,使用gcn层联合更新生成图中所有au的激活状态,其中第i个au的激活表示

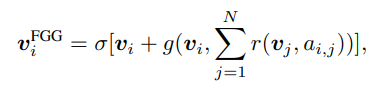

之间的连通性(边缘存在性)。具体来说,作者选择每个节点的k个最近的邻居作为它的邻居,因此图的拓扑是由学习到的节点特征定义的。然后,使用gcn层联合更新生成图中所有au的激活状态,其中第i个au的激活表示![]() 由

由![]() 生成,其连接节点为:

生成,其连接节点为:

(1)

(1)

其中![]() 为非线性激活;

为非线性激活;![]() 和

和![]() 表示gcn层的可微函数,

表示gcn层的可微函数,![]() 表示

表示![]() 和

和![]() 之间的连通性。为了为第i个au提供预测,作者提出了一种相似度计算策略(sc),该策略学习了一个与

之间的连通性。为了为第i个au提供预测,作者提出了一种相似度计算策略(sc),该策略学习了一个与![]() 具有相同维度的可训练向量

具有相同维度的可训练向量![]() ,然后通过计算

,然后通过计算![]() 与

与![]() 之间的余弦相似度来生成第i个au的出现概率:

之间的余弦相似度来生成第i个au的出现概率:

(2)

(2)

其中relu表示非线性激活。因此,具有强关联(高相似性)的一对au将具有连接的节点。换句话说,fgg块强制afg块编码节点(au)特征,这些特征包含目标面部显示的au之间的任务特定关系线索,以产生用于识别它们的最佳图。

图2.gnn网络结构

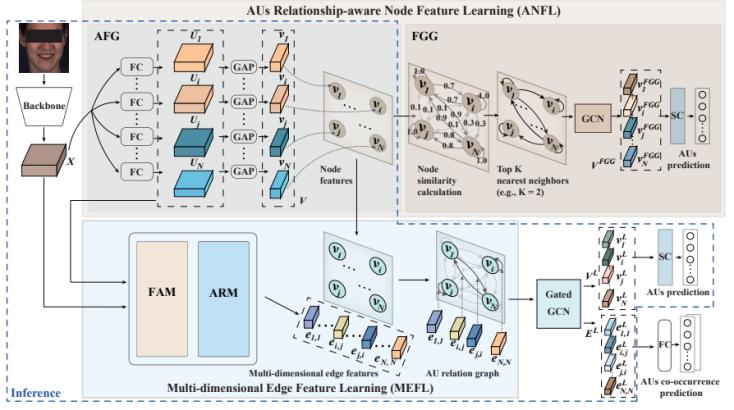

2.3多维边缘特征学习

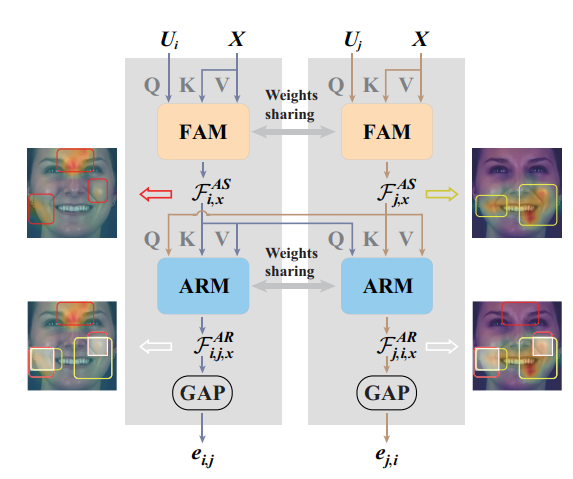

除了编码在节点特征中的关系线索,作者还提出了一个多维边缘特征学习(mefl)模块来深度学习一对多维边缘特征,旨在显式地描述每对au之间的任务特定的关系线索,学习多为边缘特征的流程如图3所示。重要的是,作者学习了论文2.1节中定义的连接和未连接节点对的边缘特征。即使一对节点的相似度很低,它们之间的关系仍然可能包含au识别的关键线索,而这些线索在节点特征学习过程中被忽略。由于一个au的激活也会影响其他au的状态,因此一对au之间的关系不仅可以通过它们的特征来反映,还可以通过其他面部区域定义的au来反映。因此,mefl模块由两个块组成:一个面部显示特定的au表示建模(fam)块,首先从完整的面部表示中定位每个au的激活线索,另一个au关系建模(arm)块,进一步从这些定位线索中提取与两个aus激活相关的特征。如图4所示,对于一对au,fam将它们的au特定的特征映射![]() 、

、![]() 和完整的面部表示x作为输入。它首先分别在

和完整的面部表示x作为输入。它首先分别在![]() 和x以及

和x以及![]() 和x之间进行交叉注意,其中au特定的特征映射

和x之间进行交叉注意,其中au特定的特征映射![]() 和

和![]() 分别用作查询,而全人脸表示x则被视为键和值。这个过程可以表述为:

分别用作查询,而全人脸表示x则被视为键和值。这个过程可以表述为:

![]() (3)

(3)

图3. 多维边缘特征学习阶段

因此,生成的![]() 和

和![]() 分别从目标面部显示的所有面部区域中提取并高亮最重要的面部线索,用于

分别从目标面部显示的所有面部区域中提取并高亮最重要的面部线索,用于![]() 和

和![]() 的识别,这考虑了面部显示的独特性对au关系的影响。

的识别,这考虑了面部显示的独特性对au关系的影响。

在为每个au的识别单独编码特定于任务的面部线索后,arm块进一步提取与两个au的识别相关的面部线索,也进行cross-attention。从数学上讲,这个过程可以表示为

![]() (4)

(4)

简而言之,编码在边缘特征![]() 和

和![]() 中的特征,总结了来自目标面部的多个与第i和第j个aus的识别相关的线索。一旦学习到由n个节点特征和n×n个多维有向边缘特征组成的aus关系图

中的特征,总结了来自目标面部的多个与第i和第j个aus的识别相关的线索。一旦学习到由n个节点特征和n×n个多维有向边缘特征组成的aus关系图![]() ,作者将其输入到gcn模型中,共同识别所有目标aus。在本文中,作者使用了包含l个图卷积层(gated gcn)的模型因此输出

,作者将其输入到gcn模型中,共同识别所有目标aus。在本文中,作者使用了包含l个图卷积层(gated gcn)的模型因此输出![]() 也是一个与

也是一个与![]() 具有相同拓扑的图,其中

具有相同拓扑的图,其中![]() 表示第i个au的激活状态。最后作者重新使用fgg块中提出的sc模块,从

表示第i个au的激活状态。最后作者重新使用fgg块中提出的sc模块,从![]() 的节点特征中预测n个au的激活,在推理阶段,只使用经过良好训练的afg和mefl来处理输入的全面表示并生成au关系图。

的节点特征中预测n个au的激活,在推理阶段,只使用经过良好训练的afg和mefl来处理输入的全面表示并生成au关系图。

图4.多维边缘特征提取过程

3.实验及结果

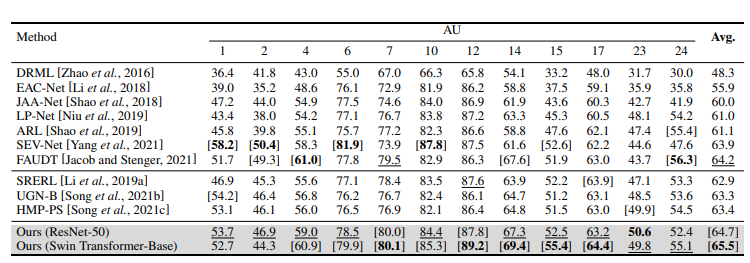

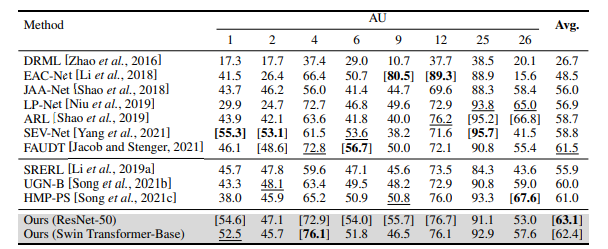

作者在bp4d和disfa两个数据集上进行了验证,对于这两个数据集,作者对每一帧进行人脸检测和对齐,并将其裁剪为224 × 224作为主干网的输入。然后,作者遵循与之前研究相同的方案对每个数据集进行受试无关的三折交叉验证,并报告平均结果。在训练过程中,作者使用了一个adamw优化器,,bp4d和disfa在fgg中选择最近邻居的k值分别设置为3和4。对于超参数λ,作者将基于resnet和swin transformer的模型分别设为0.05和0.01。作者总共训练提出的模型40个epoch,其中第一阶段20个epoch(初始学习率为1e−4),第二阶段20个epoch(初始学习率为1e−4)。

表1给出了在bp4d上的发生识别结果,可以观察到,作者所提的au关系建模方法使得主干网(resnet-50和swin transformerbase (swin- b))获得比所有其他列出的方法更高的f1总分,比最先进的方法平均提高0.5%和1.3%。

表1.bp4d数据集上au的f1分数(%)

根据表2,作者的方法使得两个主干网实现了最先进的平均f1分数,这比目前的最先进的分别提高了1.6%和0.9%。同时为了进行公平的比较,作者只将所提的方法与没有从数据集中删除任何帧的基于人脸的静态方法进行比较。

表2.disfa数据集上au的f1分数(%)

根据表1与表2,作者的基于resnet-50的系统也明显优于其他基于图的au识别方法,这些方法也使用cnn (resnet (ugn-b, hmp-ps)或vgg (ssrl))作为主干网。由于sverl仅使用预先计算的相邻矩阵来描述所有人脸au之间的关系,因此作者的系统显示出了较大的优势,bp4d和disfa的平均结果分别有1.8%和7.2%的f1分数提高。

4.总结

在这篇论文中提出了一种au关系建模方法,用一个图明确地表示每个面部显示的每对aus之间的关系线索。这些关系线索被编码在图的节点特征和多维边缘特征中。结果表明,所提出的节点和边缘特征学习方法为au识别提取了可靠的任务特定关系线索,即cnn和基于transformer的主干都得到了很大的增强,并在两个广泛使用的数据集上取得了最先进的结果。由于作者基于图的关系建模方法可以很容易地与标准cnn/transformer主干结合,因此可以通过显式地探索标签或对象之间特定于任务的关系线索,直接应用于增强多标签任务或数据包含多个对象的任务的性能。

项目k8凯发旗舰主页:https://www.chengluo.cc/projects/me-au/

论文:https://arxiv.org/pdf/2205.01782.pdf

撰稿人:李雄彬

审稿人:梁艳