作者提出了一种使用生成模型和分析体绘制图像的技术。作者使用生成对抗网络从巨大的体绘制数据集中学习一个生成模型,其中生成模型的输入是视点、不透明度和颜色的传递函数,输出为体绘制图像。作者的方法促进了体素分析的任务,这些任务是难以通过现有的渲染技术实现的。

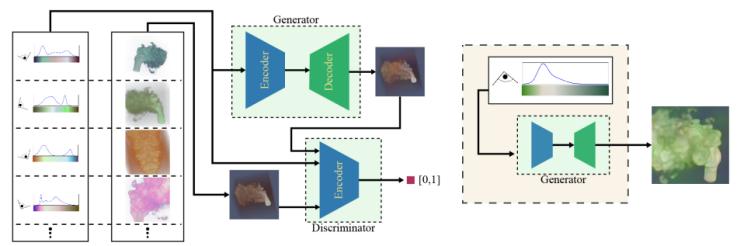

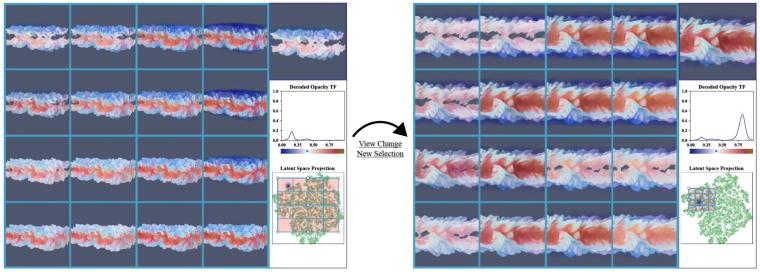

图1:基本框架和任务

作者构建了一个生成模型,该模型采用大量的体绘制图像和渲染图像所需的可视化参数,并通过生成对抗网络学习从参数到图像的映射来训练模型。训练后的模型将通过新的视点和传递函数生成图像。

对于gan来说,生成256x256的像素的彩色图片非常困难,如果生成器的数据分布和判别器的数据分布不重叠,则gan的训练是不稳定的,而且随着图像分辨率的增加,训练会更不稳定,生成的图像效果会变得非常差。

受stackgan的启发,作者将图像生成任务分解为两个更简单的生成任务,这两个任务都可以表示为相互独立的gan。第一个gan(不透明gan)将视点和不透明度传递函数作为输入,并生成64x64分辨率的不透明图像。第二个gan(颜色转换gan)将视点、不透明度传递函数再潜在空间的便是、颜色不透明度以及上一个gan所生成的不透明图像作为模型的输入,以产生最终的颜色图像。

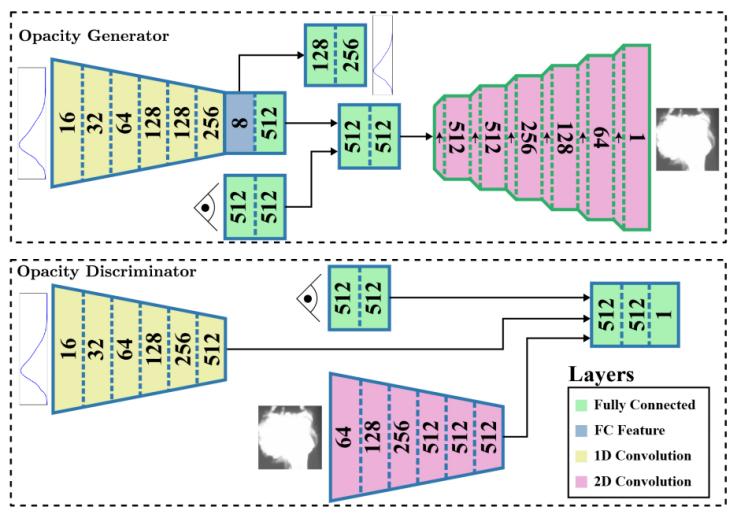

图2:不透明gan

在图2不透明gan的架构中,数字表示全连接层的特征输出维度,或卷积层中产生的通道数。1d卷积具有宽度5/步幅2,鉴别器和生成器中的2d卷积分别具有宽度4/步幅2和宽度3/步幅1。

在生成器中,不透明度传递函数通过一系列1d卷积编码到8维潜在空间中。编码的传递函数和视点然后通过单独的fc层馈送,每个fc层产生512维特征,并且这些输出被级联并馈送通过fc层,以便融合视图和tf。然后,融合的特征经过一系列交织的上采样和2d卷积层,并使用残差层来保持良好的梯度,除最后一层外的每一层都使用批次归一化。最后一层只应用卷积,然后是tanh激活函数,最终将数据范围映射到[−1,1],给出最终的不透明度图像。除此之外,作者通过两个fc层解码不透明度tf的潜在空间表示,以重建原始tf。

在判别器中,视点、不透明度tf和图像被单独处理,然后合并以产生真/假的分数。即,视点和tf分别通过fc和1d卷积层进行处理。图像通过一系列2d卷积,每个步幅为2,其中每个连续层将空间分辨率减半并增加通道数。变换后的视点、tf和图像被连接并通过fc层馈送以产生单个数值,然后使用sigmod激活函数以产生[0,1]之间的分数。

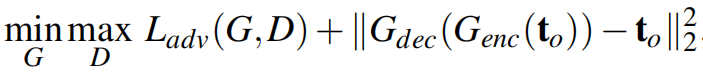

作者将对抗性损失与自动编码器损失相结合,确保传递函数潜在空间能够合成不透明度图像,并重建原始不透明度传递函数。

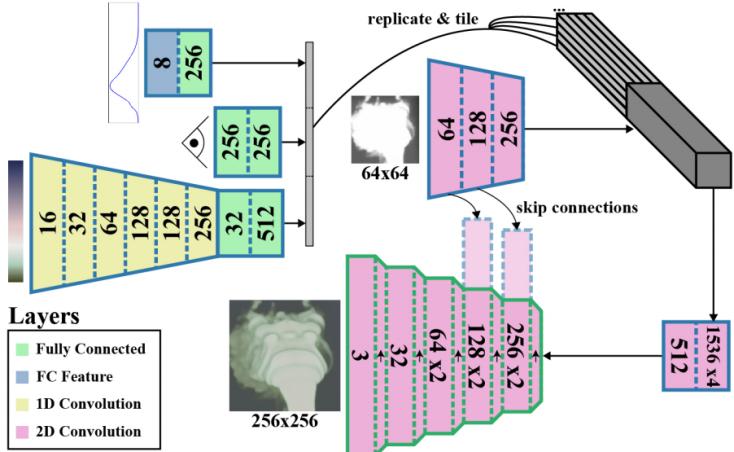

图3:颜色转换gan

在图3不透明度到颜色转换的生成器gan。跳过连接,或将不透明度图像的2d卷积编码连接到彩色图像解码的输入,有助于增强生成彩色图像的空间一致性。颜色转换gan的目标是根据视点、颜色和不透明度的传递函数以及不透明图像合成256×256分辨率的彩色图像。

生成器与不透明度gan使用相同的方式变换视点信息,同时颜色tf通过一系列1d卷积层,然后是fc层。同时,通过不透明度gan生成器的自动编码器变换不透明度tf,然后通过fc层输入。

不透明度图像使用与透明gan判别器中的不透明度图像变换的方式类似,但仅达到8×8的分辨率。然后,作者连接所有的可视化特征,然后将其作为附加通道复制并平铺到变换后的图像上。然后将其通过一系列残差层,以融合图像和可视化特征。

在合成256×256色图像时,作者使用了跳跃连接,即将不透明度图像的每个卷积层的输出连接到输出合成图像的卷积层上。跳过连接确保输出卷积层保留不透明度卷积层的空间结构,因此模型可以保留不透明度图像中固有的整体形状。在生成64×64图像时,不再有来自不透明度图像的跳过连接,而是使用标准上采样/卷积来达到256×256图像。这些上采样步骤用于有效地填充低分辨率不透明度图像可能没有捕获的细节。

判别器与不透明度gan的判别器非常相似,在判别器中没有使用不透明度图像,增加了颜色tf变换。

在损失函数方面,除了对抗性损失以外,作者基于图像的损失来补充对抗性损失,即真实图像和生成图像之间的l1范数差。

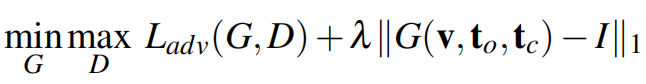

作者通过tf潜在空间采样的二维投影来展示不透明的tf探索。如图4所示,在左边,用户选择大部分投影以获得体积特征的概述,同时仍然通过投影中的直接选择来实现细节,显示为与右上图像对应的蓝色高斯斑点和右中图像重建的tf。选择右边一个较小的区域可以研究更细粒度的形状变化。

图4:不同传递函数下的合成图像

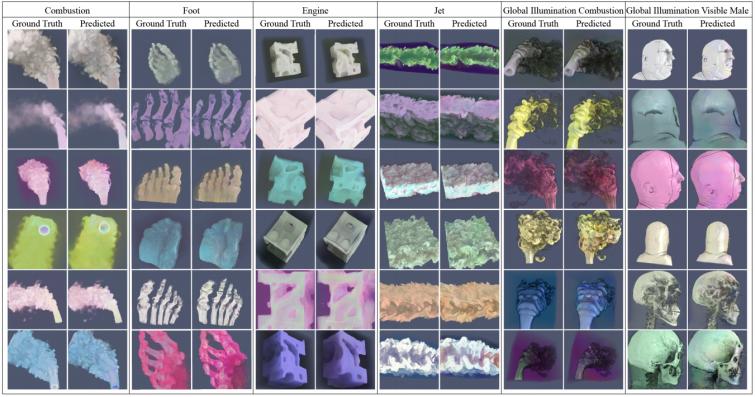

图5显示了定性结果比较生成图像与真实体积渲染产生没有照明。底部一行显示了典型的缺陷,如不正确的颜色映射和缺乏细节。

图5:tfgan的图像生成结果

参考文献:

[1] berger m, li j, levine j a. a generative model for volume rendering[j]. ieee transactions on visualization and computer graphics, 2018, 25(4): 1636-1650.

撰稿人:许景星

指导老师:罗胜舟